HDD交換&容量UP(RAID1ユニット) [サーバ]

データを保持したまま大容量のHDDに交換する手順(RAID1ユニット)。

1.前提

/dev/sdb、/dev/sdc 2台のHDDを使用して/dev/md0としてRAID1(ミラー)アレイが構築されている前提。

2.準備

RAIDを構成しているHDDより大容量のHDD × 2

3.HDD交換

①.交換するHDD(/dev/sdb)をRAIDアレイから削除する。

#mdadm /dev/md0 --fail /dev/sdb –remove /dev/sdb

②.HDDを交換し、起動する。

すると、/dev/sdbのRAIDユニットがロスト状態になっているハズ。

③.「3.RAIDの異常検出からの復旧手順④~⑥」の手順に従ってRAIDアレイの再構築を行う。

④.再構築が正常に完了した事を確認の後、/dev/sdcも同様の手順で交換、再構築を行う。

これで交換自体は完了。しかし認識する容量は元のRAIDアレイのまま。

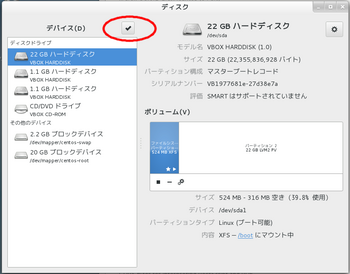

GUIツールの「ディスク」でRAIDアレイを選択すれば容量が確認可能![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

4.RAIDアレイサイズの拡張

①.アレイサイズを使用可能な最大サイズまで増加させて増加スペースは同期させない。

#mdadm --grow /dev/md0 -z max --assume-clean

mdadm: component size of /dev/md0 has been set to 4191232K

②.アレイサイズをチェックし拡張されていることを確認。

GUIツールの「ディスク」でRAIDアレイを選択すれば容量が確認可能![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

5.パーティション情報の修正

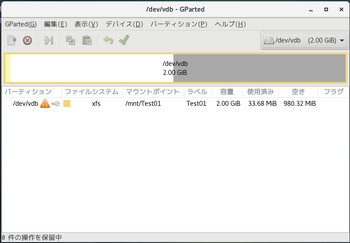

①.GPartedでパーティション情報を修正する。

「アプリケーション」-「システムツール」-「GParted」を起動。

②.交換したHDDを選択すると、パーティションに警告サインが![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

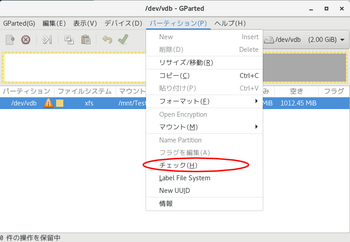

③.「パーティション」-「チェック」を選択する。

ファイルシステムをチェックして修復する処理が予約される。

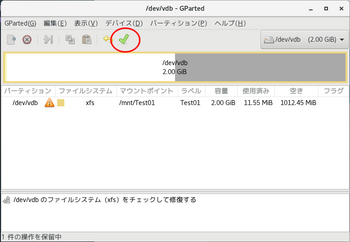

④.上記実行アイコンをクリックし保留中の処理を実行。

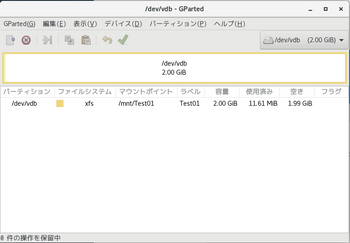

⑤.チェックが完了するとパーティション情報が修正され、容量が交換後のHDD最大サイズに拡張される。

無事に交換&容量UP完了![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

以上、データを保持したまま大容量のHDDに交換する手順(RAID1ユニット)でした。

HDD交換&容量UP(非RAID) [サーバ]

データを保持したまま大容量のHDDに交換する手順(非RAIDユニット)。

1.交換元HDDの内容を ddコマンド で新しいHDDへコピーする。

2.元のHDDを取り外し、そのポートに新しいHDDを取り付ける。

この状態で起動すると、交換自体は完了。しかし認識する容量は元のHDDのまま。

3.GPartedでパーティション情報を修正する。

「アプリケーション」-「システムツール」-「GParted」を起動。

4.交換したHDDを選択すると、パーティションに警告サインが![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

5.「パーティション」-「チェック」を選択する。

ファイルシステムをチェックして修復する処理が予約される。

6.上記実行アイコンをクリックし保留中の処理を実行。

7.チェックが完了するとパーティション情報が修正され、容量が交換後のHDD最大サイズに拡張される。

無事に交換&容量UP完了![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

以上、データを保持したまま大容量のHDDに交換する手順(非RAIDユニット)でした。

ソフトウェアRAIDの管理 [サーバ]

以前ソフトウェアRAIDをGUI操作で構築する手順を書きましたが、

状態の確認や再構築の方法等を考えるとCUI操作の方が細かく管理できそうなので、

今回はCUI操作でのソフトウェアRAIDの管理について![[あせあせ(飛び散る汗)]](https://blog.ss-blog.jp/_images_e/162.gif)

1.RAIDアレイの構築

/dev/sdb、/dev/sdc 2台のHDDを使用してRAID1(ミラー)を構築する

①.partedコマンドでRAIDユニットを作成する

コマンド:parted デバイス

#parted /dev/sdb // sdbを使用する

GNU Parted 3.1

/dev/sdb を使用

GNU Parted へようこそ! コマンド一覧を見るには 'help' と入力してください。

(parted) mklabel gpt // パーティションテーブルをgptに設定(2TB超えのHDD対応)

(parted) mkpart primary xfs 0% 100% // xfsファイルシステムで最大容量のパーティションを作成

(parted) set 1 raid on // RAIDフラグをセット![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

(parted) p // 状態確認

モデル: ATA VBOX HARDDISK (scsi)

ディスク /dev/sdb: 1074MB

セクタサイズ (論理/物理): 512B/512B

パーティションテーブル: gpt

ディスクフラグ:

番号 開始 終了 サイズ ファイルシステム 名前 フラグ

1 1049kB 1073MB 1072MB primary raid

(parted) quit // 終了

②.同様にsdcも設定する.

③.mdadmコマンドでRAIDアレイをmd0として作成する

// sdb、sdc2台のHDDでRAIDレベル1(ミラー)アレイmd0を作成

#mdadm --create /dev/md0 --level=1 --raid-devices=2 /dev/sd[bc]

④.後はGUIでの構築同様<アプリケーション>-<ユーティリティ>-「ディスク」を

使用し、RAIDアレイを初期化 → マウントすればストレージとして使用可能![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

2.DAIDの状態確認

コマンド:cat /proc/mdstat

①.RAID構築中の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdc[1] sdb[0]

1047552 blocks super 1.2 [2/2] [UU]

[==>..................] resync = 14.4% (151936/1047552) finish=0.7min speed=18992K/sec

unused devices: <none>

②.RAID状態正常の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdc[1] sdb[0]

1047552 blocks super 1.2 [2/2] [UU] // [UU]の表示が正常の証![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif)

③.RAID状態異常(HDDの異常検出)の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[0](F) sdc[1] // dev/sdbの異常を検出 (F) 表示

1047552 blocks super 1.2 [2/1] [_U] // // [_U] U → _ 表示に変わる

④.RAID状態異常(HDDロスト)の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[0] // dev/sdcが認識できない

1047552 blocks super 1.2 [2/1] [U_] // [U_] U → _ 表示に変わる

3.RAIDの異常検出からの復旧手順

1.で構築のRAID構成にて /dev/sdb HDDの異常を検出した想定

①.DAIDの状態を確認

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[0](F) sdc[1] // dev/sdbの異常を検出 (F) 表示

1047552 blocks super 1.2 [2/1] [_U] // // [_U] U → _ 表示に変わる

②.障害発生HDDをRAIDアレイから切り離し

#mdadm --remove /dev/md0 /dev/sdb

mdadm: hot removed /dev/sdb from /dev/md0

③.障害発生HDDを交換する

④.1 - ①の手順でRAIDユニット再作成

⑤.RAIDアレイ再構築

#mdadm --manage /dev/md0 --add /dev/sdb

mdadm: added /dev/sdb

⑥.DAIDの状態を確認

// 再構築中

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[2] sdc[1]

1047552 blocks super 1.2 [2/1] [_U]

[==>..................] recovery = 12.8% (135552/1047552) finish=0.5min speed=27110K/sec

↓↓↓

// 再構築完了

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdc[1] sdb[0]

1047552 blocks super 1.2 [2/2] [UU]

4.その他

RAIDアレイを削除する

#mdadm --misc --stop /dev/md0

以上、CUI操作でのソフトウェアRAIDの管理についてでした。

状態の確認や再構築の方法等を考えるとCUI操作の方が細かく管理できそうなので、

今回はCUI操作でのソフトウェアRAIDの管理について

1.RAIDアレイの構築

/dev/sdb、/dev/sdc 2台のHDDを使用してRAID1(ミラー)を構築する

①.partedコマンドでRAIDユニットを作成する

コマンド:parted デバイス

#parted /dev/sdb // sdbを使用する

GNU Parted 3.1

/dev/sdb を使用

GNU Parted へようこそ! コマンド一覧を見るには 'help' と入力してください。

(parted) mklabel gpt // パーティションテーブルをgptに設定(2TB超えのHDD対応)

(parted) mkpart primary xfs 0% 100% // xfsファイルシステムで最大容量のパーティションを作成

(parted) set 1 raid on // RAIDフラグをセット

(parted) p // 状態確認

モデル: ATA VBOX HARDDISK (scsi)

ディスク /dev/sdb: 1074MB

セクタサイズ (論理/物理): 512B/512B

パーティションテーブル: gpt

ディスクフラグ:

番号 開始 終了 サイズ ファイルシステム 名前 フラグ

1 1049kB 1073MB 1072MB primary raid

(parted) quit // 終了

②.同様にsdcも設定する.

③.mdadmコマンドでRAIDアレイをmd0として作成する

// sdb、sdc2台のHDDでRAIDレベル1(ミラー)アレイmd0を作成

#mdadm --create /dev/md0 --level=1 --raid-devices=2 /dev/sd[bc]

④.後はGUIでの構築同様<アプリケーション>-<ユーティリティ>-「ディスク」を

使用し、RAIDアレイを初期化 → マウントすればストレージとして使用可能

2.DAIDの状態確認

コマンド:cat /proc/mdstat

①.RAID構築中の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdc[1] sdb[0]

1047552 blocks super 1.2 [2/2] [UU]

[==>..................] resync = 14.4% (151936/1047552) finish=0.7min speed=18992K/sec

unused devices: <none>

②.RAID状態正常の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdc[1] sdb[0]

1047552 blocks super 1.2 [2/2] [UU] // [UU]の表示が正常の証

③.RAID状態異常(HDDの異常検出)の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[0](F) sdc[1] // dev/sdbの異常を検出 (F) 表示

1047552 blocks super 1.2 [2/1] [_U] // // [_U] U → _ 表示に変わる

④.RAID状態異常(HDDロスト)の場合

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[0] // dev/sdcが認識できない

1047552 blocks super 1.2 [2/1] [U_] // [U_] U → _ 表示に変わる

3.RAIDの異常検出からの復旧手順

1.で構築のRAID構成にて /dev/sdb HDDの異常を検出した想定

①.DAIDの状態を確認

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[0](F) sdc[1] // dev/sdbの異常を検出 (F) 表示

1047552 blocks super 1.2 [2/1] [_U] // // [_U] U → _ 表示に変わる

②.障害発生HDDをRAIDアレイから切り離し

#mdadm --remove /dev/md0 /dev/sdb

mdadm: hot removed /dev/sdb from /dev/md0

③.障害発生HDDを交換する

④.1 - ①の手順でRAIDユニット再作成

⑤.RAIDアレイ再構築

#mdadm --manage /dev/md0 --add /dev/sdb

mdadm: added /dev/sdb

⑥.DAIDの状態を確認

// 再構築中

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdb[2] sdc[1]

1047552 blocks super 1.2 [2/1] [_U]

[==>..................] recovery = 12.8% (135552/1047552) finish=0.5min speed=27110K/sec

↓↓↓

// 再構築完了

#cat /proc/mdstat

Personalities : [raid1]

md0 : active raid1 sdc[1] sdb[0]

1047552 blocks super 1.2 [2/2] [UU]

4.その他

RAIDアレイを削除する

#mdadm --misc --stop /dev/md0

以上、CUI操作でのソフトウェアRAIDの管理についてでした。

DLNA機能実装-5- [サーバ]

UMS(Universal Media Server)のバージョンアップ方法について![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

まず、起動しているUMSを停止する。

# systemctl stop ums

バージョンアップするUMS本体を以下からダウンロード

http://www.universalmediaserver.com/

ファイルを展開しできたUMS-x.x.xフォルダを /optフォルダへ移動する。

# mv ums-x.x.x /opt

(x,x,xはバージョン番号)

/optフォルダのシンボリックリンクumsを解除する。

次に移動したUMS-x.x.xフォルダへのシンボリックリンクをumsとして再作成する。

(シンボリックリンクの操作方法はココを参照。)

旧バージョンumsフォルダのrenderersフォルダを新バージョンumsフォルダへコピーする。

(トランスコード設定をカスタムしている場合、これを忘れると設定が引き継がれません![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif) )

)

UMSを再起動する。

# systemctl start ums

正常に再起動できた事を確認してバージョンアップ完了![[exclamation×2]](https://blog.ss-blog.jp/_images_e/160.gif)

# systemctl -l status ums

\u25cf ums.service - Universal Media Server

Loaded: loaded (/etc/systemd/system/ums.service; enabled; vendor preset: disabled)

Active: active (running) since \u65e5 2016-10-30 21:16:27 JST; 2s ago

Main PID: 14566 (java)

CGroup: /system.slice/ums.service

\u2514\u250014566 java -Xmx768M -Xss2048k -Dfile.encoding=UTF-8

以上、UMS(Universal Media Server)のバージョンアップについてでした。

まず、起動しているUMSを停止する。

# systemctl stop ums

バージョンアップするUMS本体を以下からダウンロード

http://www.universalmediaserver.com/

ファイルを展開しできたUMS-x.x.xフォルダを /optフォルダへ移動する。

# mv ums-x.x.x /opt

(x,x,xはバージョン番号)

/optフォルダのシンボリックリンクumsを解除する。

次に移動したUMS-x.x.xフォルダへのシンボリックリンクをumsとして再作成する。

(シンボリックリンクの操作方法はココを参照。)

旧バージョンumsフォルダのrenderersフォルダを新バージョンumsフォルダへコピーする。

(トランスコード設定をカスタムしている場合、これを忘れると設定が引き継がれません

UMSを再起動する。

# systemctl start ums

正常に再起動できた事を確認してバージョンアップ完了

# systemctl -l status ums

\u25cf ums.service - Universal Media Server

Loaded: loaded (/etc/systemd/system/ums.service; enabled; vendor preset: disabled)

Active: active (running) since \u65e5 2016-10-30 21:16:27 JST; 2s ago

Main PID: 14566 (java)

CGroup: /system.slice/ums.service

\u2514\u250014566 java -Xmx768M -Xss2048k -Dfile.encoding=UTF-8

以上、UMS(Universal Media Server)のバージョンアップについてでした。

DLNA機能実装-4- [サーバ]

前回UMS(Universal Media Server)のインストールを行ったので、

今回は設定~起動![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

/etc/UMS.conf を環境に合わせて編集する。

↓デフォルト値から変更したとは以下の通り

server_name = Universal Media Server ← クライアントに表示されるDLNAサーバの名称を指定

・

・

・

公開するフォルダを指定

folders = /mnt/・・・/Video, /mnt/・・・/Music, /mnt/・・・/Pictures

後はサービスを起動して、自動起動設定をする。

# systemctl start ums ← サービス起動

# systemctl enable ums ← 自動起動登録

クライアントからうまく表示されない時は以下で状態確認

# systemctl -l status ums

以上、UMS(Universal Media Server)の設定~起動でした。

今回は設定~起動

/etc/UMS.conf を環境に合わせて編集する。

↓デフォルト値から変更したとは以下の通り

server_name = Universal Media Server ← クライアントに表示されるDLNAサーバの名称を指定

・

・

・

公開するフォルダを指定

folders = /mnt/・・・/Video, /mnt/・・・/Music, /mnt/・・・/Pictures

後はサービスを起動して、自動起動設定をする。

# systemctl start ums ← サービス起動

# systemctl enable ums ← 自動起動登録

クライアントからうまく表示されない時は以下で状態確認

# systemctl -l status ums

以上、UMS(Universal Media Server)の設定~起動でした。

DLNA機能実装-3- [サーバ]

今回はトランスコード機能を持った

UMS(Universal Media Server)をインストールしてみる![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

まず必要なパッケージをインストール

# yum install http://dl.fedoraproject.org/pub/epel/7/x86_64/e/epel-release-7-2.noarch.rpm

# yum install http://li.nux.ro/download/nux/dextop/el7/x86_64/nux-dextop-release-0-1.el7.nux.noarch.rpm

# yum install mplayer mencoder ffmpeg mediainfo

UMS本体"UMS-5.3.1-Java7.tgz"を以下からダウンロード

http://www.universalmediaserver.com/

ファイルを展開しできたUMS-5.3.1フォルダを /optフォルダへ移動する。

# mv ums-5.3.1 /opt

/opt/ums-5.3.1フォルダのシンボリックリンクを/opt/umsに作成する。

# ln -s /opt/ums-5.3.1 /opt/ums

/etc/umsフォルダを作成しここにUMS.conf WEB.conf をコピーする。

# mkdir /etc/ums

# cp /opt/ums/UMS.conf /opt/ums/WEB.conf /etc/ums

ユーザ”ums”を作成する。

ホームディレクトリ:/opt/ums

ログインシェル:/sbin/nologin

# useradd -d /opt/ums -s /sbin/nologin ums

ファイルの所有者を”ums”に変更

-Rフォルダ全体オプション

# chown -R ums:ums /opt/ums-5.3.1

# chown -R ums:ums /etc/ums

サービス登録用の/etc/systemd/system/ums.serviceを以下の内容で作成

[Unit]

Description=Universal Media Server

[Service]

Type=simple

Environment="UMS_PROFILE=/etc/ums/UMS.conf"

User=ums

Group=ums

ExecStart=/opt/ums/UMS.sh

[Install]

WantedBy=multi-user.target

以上でインストール自体は完了。

次回、設定 ~ 起動に続く・・・

↓この内容は以下のページで詳しく説明されている。

http://mikeshoup.com/2014/11/30/universal-media-server-on-centos-7/

UMS(Universal Media Server)をインストールしてみる

まず必要なパッケージをインストール

# yum install http://dl.fedoraproject.org/pub/epel/7/x86_64/e/epel-release-7-2.noarch.rpm

# yum install http://li.nux.ro/download/nux/dextop/el7/x86_64/nux-dextop-release-0-1.el7.nux.noarch.rpm

# yum install mplayer mencoder ffmpeg mediainfo

UMS本体"UMS-5.3.1-Java7.tgz"を以下からダウンロード

http://www.universalmediaserver.com/

ファイルを展開しできたUMS-5.3.1フォルダを /optフォルダへ移動する。

# mv ums-5.3.1 /opt

/opt/ums-5.3.1フォルダのシンボリックリンクを/opt/umsに作成する。

# ln -s /opt/ums-5.3.1 /opt/ums

/etc/umsフォルダを作成しここにUMS.conf WEB.conf をコピーする。

# mkdir /etc/ums

# cp /opt/ums/UMS.conf /opt/ums/WEB.conf /etc/ums

ユーザ”ums”を作成する。

ホームディレクトリ:/opt/ums

ログインシェル:/sbin/nologin

# useradd -d /opt/ums -s /sbin/nologin ums

ファイルの所有者を”ums”に変更

-Rフォルダ全体オプション

# chown -R ums:ums /opt/ums-5.3.1

# chown -R ums:ums /etc/ums

サービス登録用の/etc/systemd/system/ums.serviceを以下の内容で作成

[Unit]

Description=Universal Media Server

[Service]

Type=simple

Environment="UMS_PROFILE=/etc/ums/UMS.conf"

User=ums

Group=ums

ExecStart=/opt/ums/UMS.sh

[Install]

WantedBy=multi-user.target

以上でインストール自体は完了。

次回、設定 ~ 起動に続く・・・

↓この内容は以下のページで詳しく説明されている。

http://mikeshoup.com/2014/11/30/universal-media-server-on-centos-7/

DLNA機能実装-2- [サーバ]

前回MiniDLNAのインストールを行ったので、

今回は設定~起動![[exclamation]](https://blog.ss-blog.jp/_images_e/158.gif)

/etc/minidlna.conf を環境に合わせて編集する。

↓デフォルト値から変更したとは以下の通り

user=minidlna ← 実行ユーザを指定する

・

・

・

公開するフォルダを指定

media_dir=A,/mnt/・・・/Music ←先頭に"A,"を付けてフォルダを指定すると音楽フォルダ

media_dir=V,/mnt/・・・/Video ←先頭に"V,"を付けてフォルダを指定するとムービーフォルダ

media_dir=P,/mnt/・・・/Pictures ←先頭に"P,"を付けてフォルダを指定すると画像フォルダ

![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif) 先頭のA,V,P指定をしないと無指定

先頭のA,V,P指定をしないと無指定

![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif) 画像フォルダはなぜか"Pictures"の名称でないとうまく公開されない

画像フォルダはなぜか"Pictures"の名称でないとうまく公開されない![[たらーっ(汗)]](https://blog.ss-blog.jp/_images_e/163.gif) 我が家の環境だけ

我が家の環境だけ![[exclamation&question]](https://blog.ss-blog.jp/_images_e/159.gif)

![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif) 配信したいフォルダが複数ある場合はシンボリックリンクを使用して1つのフォルダにまとめておき、これを公開すると管理が楽

配信したいフォルダが複数ある場合はシンボリックリンクを使用して1つのフォルダにまとめておき、これを公開すると管理が楽![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

・

・

・

friendly_name=MiniDLNA Server ← クライアントに表示されるDLNAサーバの名称を指定

・

・

・

db_dir=/mnt/・・・/Cache/MiniDLNA ← MiniDLNAが管理する公開ファイルのデータベースファイルの保存先を指定

後はサービスを起動して、自動起動設定をする。

# systemctl start minidlna ← サービス起動

# systemctl enable minidlna ← 自動起動登録

クライアントからうまく表示されない時は以下で状態確認

# systemctl -l status minidlna

以上、MiniDLNAの設定~起動でした。

今回は設定~起動

/etc/minidlna.conf を環境に合わせて編集する。

↓デフォルト値から変更したとは以下の通り

user=minidlna ← 実行ユーザを指定する

・

・

・

公開するフォルダを指定

media_dir=A,/mnt/・・・/Music ←先頭に"A,"を付けてフォルダを指定すると音楽フォルダ

media_dir=V,/mnt/・・・/Video ←先頭に"V,"を付けてフォルダを指定するとムービーフォルダ

media_dir=P,/mnt/・・・/Pictures ←先頭に"P,"を付けてフォルダを指定すると画像フォルダ

・

・

・

friendly_name=MiniDLNA Server ← クライアントに表示されるDLNAサーバの名称を指定

・

・

・

db_dir=/mnt/・・・/Cache/MiniDLNA ← MiniDLNAが管理する公開ファイルのデータベースファイルの保存先を指定

後はサービスを起動して、自動起動設定をする。

# systemctl start minidlna ← サービス起動

# systemctl enable minidlna ← 自動起動登録

クライアントからうまく表示されない時は以下で状態確認

# systemctl -l status minidlna

以上、MiniDLNAの設定~起動でした。

DLNA機能実装-1- [サーバ]

テレビでサーバ内の写真などが見られるようにDLNA機能を実装する。

インストールするのは"MiniDLNA"というDLNAサーバ![[exclamation×2]](https://blog.ss-blog.jp/_images_e/160.gif)

(詳しく無いんだけど有名![[exclamation&question]](https://blog.ss-blog.jp/_images_e/159.gif) )

)

↓手順は以下で公開されている"Nux Dextop"リポジトリを追加し、yum インストールする。

http://li.nux.ro/repos.html

端末より

必要なパッケージのインストール

# yum install epel-release

リポジトリの追加

# rpm -Uvh http://li.nux.ro/download/nux/dextop/el7/x86_64/nux-dextop-release-0-5.el7.nux.noarch.rpm

MiniDLNAをインストール

# yum install minidlna

以上でインストール自体は完了。

yumインストールできるととても簡単だ![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

次回、設定 ~ 起動に続く・・・

インストールするのは"MiniDLNA"というDLNAサーバ

(詳しく無いんだけど有名

↓手順は以下で公開されている"Nux Dextop"リポジトリを追加し、yum インストールする。

http://li.nux.ro/repos.html

端末より

必要なパッケージのインストール

# yum install epel-release

リポジトリの追加

# rpm -Uvh http://li.nux.ro/download/nux/dextop/el7/x86_64/nux-dextop-release-0-5.el7.nux.noarch.rpm

MiniDLNAをインストール

# yum install minidlna

以上でインストール自体は完了。

yumインストールできるととても簡単だ

次回、設定 ~ 起動に続く・・・

ソフトウェアRAIDをGUI操作で構築する [サーバ]

HDDのトラブルからファイル共有のデータを保護するために

ソフトウェアRAID(ミラー)を構築する。

しかもGUI操作で![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif) (ココ重要

(ココ重要![[exclamation×2]](https://blog.ss-blog.jp/_images_e/160.gif) )

)

[準備]

今回はRAID1(ミラーリング)での構築を行うので、同容量のHDDを2個準備しPCに接続する。

![[ひらめき]](https://blog.ss-blog.jp/_images_e/151.gif) SATA接続の場合、HDDは”/dev/sdb”、"/dev/sdc”のように認識する筈であるが、

SATA接続の場合、HDDは”/dev/sdb”、"/dev/sdc”のように認識する筈であるが、

実際のHDDのどちらに該当するか調べておく事。障害発生時にどっちのHDDを交換すれば良いか解らなくなる![[あせあせ(飛び散る汗)]](https://blog.ss-blog.jp/_images_e/162.gif)

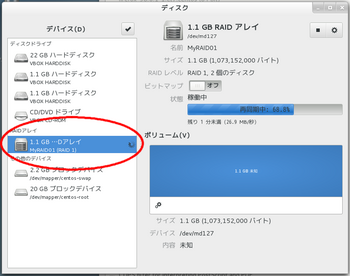

[ここからRAID構築]

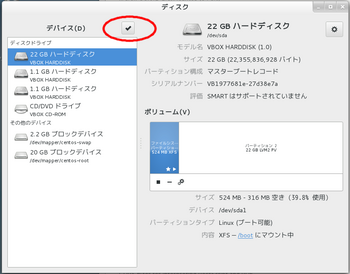

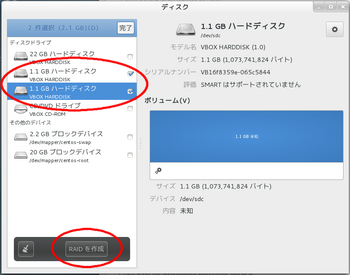

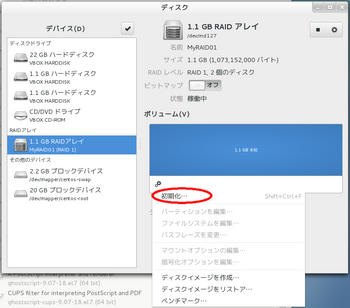

<アプリケーション>-<ユーティリティ>-「ディスク」を起動する。

「デバイス」右横のチェックボタンをクリックする。

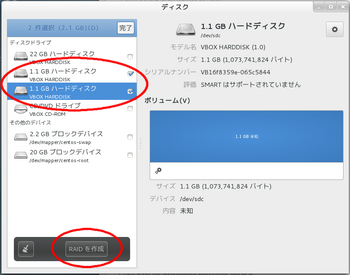

RAIDを構築するHDDをにチェックを付けて「RAIDを作成」をクリックする。

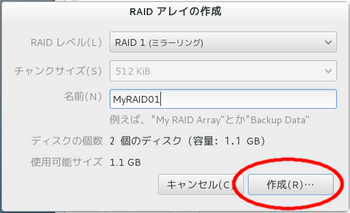

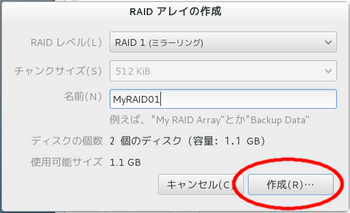

RAIDレベルで「RAID1(ミラーリング)」を選択し、名前を付けて「作成」をクリックする。

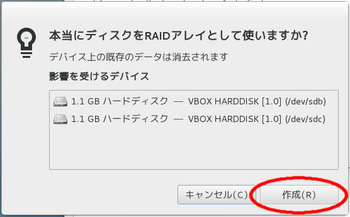

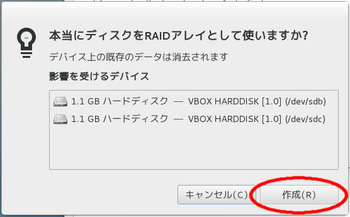

構成内容を確認し、「作成」をクリックする。

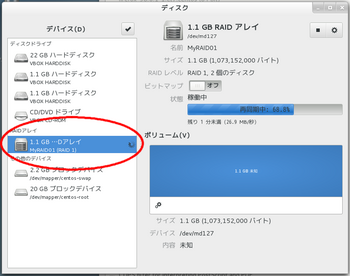

デバイス欄に先に名前を付けた内容でRAIDアレイが作成できている筈![[exclamation]](https://blog.ss-blog.jp/_images_e/158.gif)

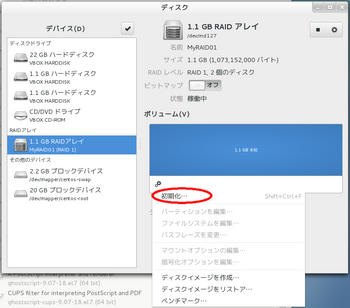

「設定」アイコンから「初期化」を選択する。

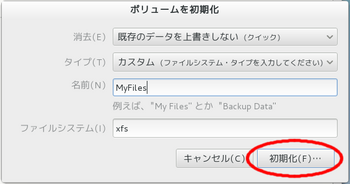

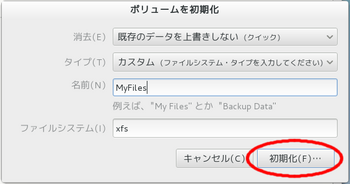

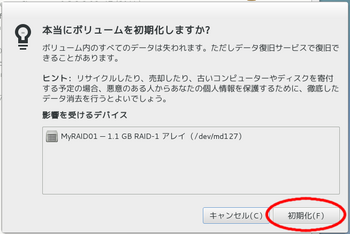

ファイルシステム、名前を設定し「初期化」をクリックする。

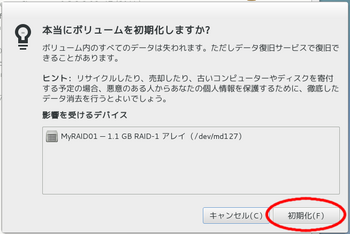

内容を確認し「初期化」を実行する。

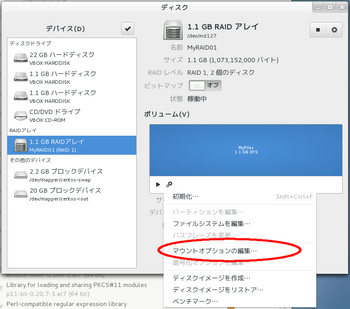

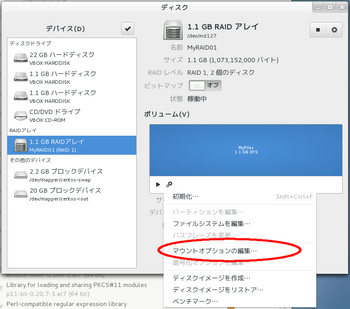

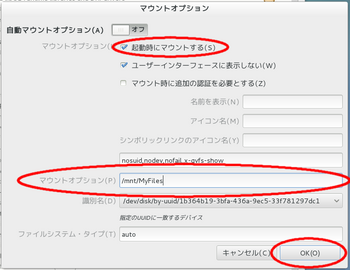

「設定」アイコンから「マウントオプションの編集」を選択する。

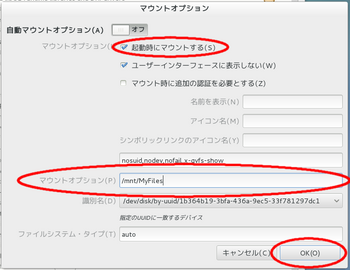

「起動時にマウントする」にチェックを付け、マウントオプションでマウント先を指定する。

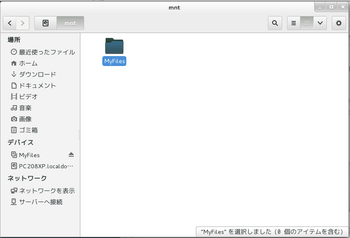

「OK」をクリックするとマウントされる。

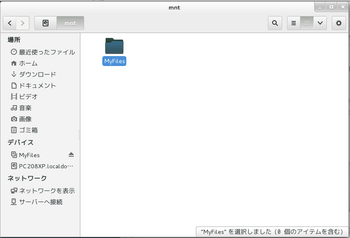

無事マウント完了![[手(チョキ)]](https://blog.ss-blog.jp/_images_e/87.gif) 再起動しても自動マウントされ、RAIDドライブと言っても普通のHDDと同様に利用できる。

再起動しても自動マウントされ、RAIDドライブと言っても普通のHDDと同様に利用できる。

以上、ソフトウェアRAIDをGUI操作で構築するでした。

ソフトウェアRAID(ミラー)を構築する。

しかもGUI操作で

[準備]

今回はRAID1(ミラーリング)での構築を行うので、同容量のHDDを2個準備しPCに接続する。

実際のHDDのどちらに該当するか調べておく事。障害発生時にどっちのHDDを交換すれば良いか解らなくなる

[ここからRAID構築]

<アプリケーション>-<ユーティリティ>-「ディスク」を起動する。

「デバイス」右横のチェックボタンをクリックする。

RAIDを構築するHDDをにチェックを付けて「RAIDを作成」をクリックする。

RAIDレベルで「RAID1(ミラーリング)」を選択し、名前を付けて「作成」をクリックする。

構成内容を確認し、「作成」をクリックする。

デバイス欄に先に名前を付けた内容でRAIDアレイが作成できている筈

「設定」アイコンから「初期化」を選択する。

ファイルシステム、名前を設定し「初期化」をクリックする。

内容を確認し「初期化」を実行する。

「設定」アイコンから「マウントオプションの編集」を選択する。

「起動時にマウントする」にチェックを付け、マウントオプションでマウント先を指定する。

「OK」をクリックするとマウントされる。

無事マウント完了

以上、ソフトウェアRAIDをGUI操作で構築するでした。

VNC Server 接続不具合 [サーバ]

突然VNCサーバに接続できなくなり、状況調査と修復を行う![[あせあせ(飛び散る汗)]](https://blog.ss-blog.jp/_images_e/162.gif)

まず、サービスの状態を確認してみるとサービスの起動に失敗している模様![[バッド(下向き矢印)]](https://blog.ss-blog.jp/_images_e/156.gif)

# systemctl status vncserver@:1.service

vncserver@:1.service - Remote desktop service (VNC)

Loaded: loaded (/etc/systemd/system/vncserver@:1.service; enabled)

Active: failed (Result: exit-code) since ? 2015-06-29 21:38:21 JST; 8min ago

Process: 962 ExecStart=/sbin/runuser -l testuser1 -c /usr/bin/vncserver %i (code=exited, status=2)

Process: 947 ExecStartPre=/bin/sh -c /usr/bin/vncserver -kill %i > /dev/null 2>&1 || : (code=exited, status=0/SUCCESS)

6月 29 21:38:21 XXXXX.test-ad.local runuser[962]: A VNC server is already...

6月 29 21:38:21 XXXXX.test-ad.local systemd[1]: vncserver@:1.service: con... ← サービスの起動に失敗している

6月 29 21:38:21 XXXXX.test-ad.local systemd[1]: Failed to start Remote de...

6月 29 21:38:21 XXXXX.test-ad.local systemd[1]: Unit vncserver@:1.service...

Hint: Some lines were ellipsized, use -l to show in full.

次にVNCサーバを起動してみると、既に起動しているとか・・・![[たらーっ(汗)]](https://blog.ss-blog.jp/_images_e/163.gif)

でも、サーバが無いようなら/tmp/.X11-unix/X1を削除しなさいとか言っている![[exclamation&question]](https://blog.ss-blog.jp/_images_e/159.gif)

# vncserver :1

Warning: XXXXX.test-ad.local:1 is taken because of /tmp/.X11-unix/X1

Remove this file if there is no X server XXXXX.test-ad.local:1

A VNC server is already running as :1

サーバに繋がらないんだから/tmp/.X11-unix/X1を削除する![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

# rm /tmp/.X11-unix/X1

rm: ソケット `/tmp/.X11-unix/X1' を削除しますか? ← yを入力

新しいメールが /var/spool/mail/root にあります

再度VNCサーバを起動してみると無事に起動![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

![[るんるん]](https://blog.ss-blog.jp/_images_e/146.gif)

# vncserver :1

New 'XXXXX.test-ad.local:1 (root)' desktop is XXXXX.test-ad.local:1

Starting applications specified in /root/.vnc/xstartup

Log file is /root/.vnc/XXXXX.test-ad.local:1.log

サービスとしての起動も問題無し![[exclamation×2]](https://blog.ss-blog.jp/_images_e/160.gif)

以上、VNC Server 接続不具合からの復旧でした。

まず、サービスの状態を確認してみるとサービスの起動に失敗している模様

# systemctl status vncserver@:1.service

vncserver@:1.service - Remote desktop service (VNC)

Loaded: loaded (/etc/systemd/system/vncserver@:1.service; enabled)

Active: failed (Result: exit-code) since ? 2015-06-29 21:38:21 JST; 8min ago

Process: 962 ExecStart=/sbin/runuser -l testuser1 -c /usr/bin/vncserver %i (code=exited, status=2)

Process: 947 ExecStartPre=/bin/sh -c /usr/bin/vncserver -kill %i > /dev/null 2>&1 || : (code=exited, status=0/SUCCESS)

6月 29 21:38:21 XXXXX.test-ad.local runuser[962]: A VNC server is already...

6月 29 21:38:21 XXXXX.test-ad.local systemd[1]: vncserver@:1.service: con... ← サービスの起動に失敗している

6月 29 21:38:21 XXXXX.test-ad.local systemd[1]: Failed to start Remote de...

6月 29 21:38:21 XXXXX.test-ad.local systemd[1]: Unit vncserver@:1.service...

Hint: Some lines were ellipsized, use -l to show in full.

次にVNCサーバを起動してみると、既に起動しているとか・・・

でも、サーバが無いようなら/tmp/.X11-unix/X1を削除しなさいとか言っている

# vncserver :1

Warning: XXXXX.test-ad.local:1 is taken because of /tmp/.X11-unix/X1

Remove this file if there is no X server XXXXX.test-ad.local:1

A VNC server is already running as :1

サーバに繋がらないんだから/tmp/.X11-unix/X1を削除する

# rm /tmp/.X11-unix/X1

rm: ソケット `/tmp/.X11-unix/X1' を削除しますか? ← yを入力

新しいメールが /var/spool/mail/root にあります

再度VNCサーバを起動してみると無事に起動

# vncserver :1

New 'XXXXX.test-ad.local:1 (root)' desktop is XXXXX.test-ad.local:1

Starting applications specified in /root/.vnc/xstartup

Log file is /root/.vnc/XXXXX.test-ad.local:1.log

サービスとしての起動も問題無し

以上、VNC Server 接続不具合からの復旧でした。